Lineáris regresszió

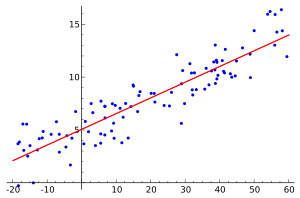

A statisztika eszköztárában a lineáris regresszió egy olyan paraméteres regressziós modell, mely feltételezi a magyarázó- (X) és a magyarázott (y) változó közti (paramétereiben) lineáris kapcsolatot. Ez azt jelenti, hogy lineáris regresszió becslése során a mintavételi adatok pontfelhőjére igyekszünk egyenest[1] illeszteni.

A lineáris kapcsolat a következőképpen fejezhető ki:

ahol , vektorok, mátrix, vektor minden -ra, a magyarázóváltozók száma (konstanssal együtt), a mintanagyság.

A lineáris regresszió becslése során a paramétervektort becsüljük a rendelkezésre álló mintából úgy, hogy az pl. az átlagos négyzetes hibát minimalizálja. A legegyszerűbb, és legáltalánosabb becslési módszer a legkisebb négyzetek módszere, azonban ez utóbbi nem tévesztendő össze a lineáris regresszió fogalmával, mivel lineáris regressziós egyenest más becslési módszerekkel is becsülhetjük, és a legkisebb négyzetek módszere nem csak lineáris regressziós modellek becslésére alkalmas.

A lineáris regressziós elemzést és becslést mindig elvégezhetjük, azonban az eredmények értelmezése a valós populációs összefüggésekre tett különböző feltételezések megtételéhez kötött.

A becsült lineáris regressziós egyenes többféleképpen értelmezhető:

- Értelmezhető deskriptív módon úgy, hogy ez az a lineáris függvény, ami a legjobban illeszkedik az adott ponthalmazra. Amennyiben az egyenest valóban illeszteni tudjuk, erre az értelmezésre mindig lehetőségünk van egyéb feltételezésektől függetlenül.

- Az előző ponthoz kapcsolódóan lehetőségünk van arra, hogy megbecsüljük, vagy előrejelezzük a magyarázott változó olyan értékét, amelyhez a mintában nem tartozik magyarázó változó érték. Ebben az esetben a lineáris regressziós egyenes adja a magyarázott változó legjobb lineáris közelítését a magyarázó változó adott értéke mellett.

- Értelmezhetjük úgy, hogy a regressziós egyenes egy átfogó képet ad arról, hogy y várhatóan hogyan változik X változásának hatására. Ez esetben a következőt mondhatjuk a lineáris regressziós becslés és a feltételes átlagfüggvény kapcsolatáról:

- Amennyiben a feltételes átlagfüggvény, lineáris β-ban, akkor a becsült lineáris regressziós függvény egybeesik azzal, tehát az eredmények várható érték alapú értelmezése korrekt.

- Amennyiben a feltételes átlagfüggvény nemlineáris, a becsült lineáris regressziós függvény a legjobb lineáris közelítése annak. Ez esetben ugyan a várható érték alapú értelmezés nem teljes mértékben korrekt, mégis hasznos, értelmezhető információval szolgálhatunk a becslés eredményeit vizsgálva és körültekintően értelmezve.

A magyarázóváltozók száma alapján megkülönböztetünk egyszerű vagy többszörös lineáris regressziót, az adatok X mátrixa pedig lehet véletlen vagy rögzített.

Alapfogalmak és egyszerű lineáris regresszió[szerkesztés]

A regressziós modellekben

- -t magyarázandó, függő, vagy eredményváltozónak,

- -et a magyarázó- vagy független változónak,

- -t (gyakran -t) hibatagnak, maradékváltozónak,

- -t paraméternek, koefficiensnek

nevezzük.

Az egyszerű lineáris regresszió modelljében -t egy változóval, egy konstanssal és a hibataggal magyarázzuk. Amennyiben rendelkezésünkre áll egy n elemű minta , a regressziós modellt, amit becsülni kívánunk, a következőképpen írhatjuk:

- minden -re.

A modell becsült paraméterei és (lényegében a legtöbb becslési eljárás eredményeképp) rendre a regressziós egyenes tengelymetszetét és meredekségét adják. Belátható, hogy az egyszerű lineáris regressziós modellben a becsült paraméterek értéke a következőképpen számítható:

amely egyenletekben a függő változó mintaátlaga, a független változó mintaátlaga, vektor és vektor ( a transzponálást jelöli).

E formulákból a lineáris regresszió intuitív értelmezése látható: 1.) a tengelymetszet a független változó átlagát adja, amennyiben a magyarázó változó értéke (átlagban vagy egyenként) nulla, 2.) a meredekség a két változó közti kovarianciát, "együttmozgást" mutatja (megfelelő normalizálás mellett).

Megjegyzendő, hogy a konstans tag elhagyható a modellből, ez esetben azonban a becsült regressziós egyenest "átkényszerítjük" az origón. Ez általában rosszabb illeszkedést idéz elő.

A lineáris regresszió alkalmazásának feltételei[szerkesztés]

Lásd még: Legkisebb négyzetek módszere § Mellékfeltételek

A standard lineáris regressziós modellek használata a standard becslési technikákkal számos – a magyarázó (x) és kimeneti (y) változókra, illetve ezek kapcsolatára vonatkozó - feltételhez kötött. Ezeknek a kritériumoknak az enyhítésére (vagy akár teljes kiküszöbölésére) különböző kiterjesztett eljárásokat fejlesztettek ki, amelyek általában bonyolultabbá és időigényesebbé teszik a becslési eljárást, illetve több adatra is szükség lehet ugyanolyan precíz modell elkészítéséhez. Az alábbiakban azok a főbb feltételek kerülnek bemutatásra, amelyeket a standard lineáris regressziós modellek alkalmazásakor használunk standard becslési technikákkal (pl. a Legkisebb négyzetek módszere):

- Gyenge exogenitás. Ez lényegében azt jelenti, hogy a magyarázó változók (x) fix értékekként kezelhetők, nem pedig valószínűségi változókként. Ez azt jelenti például, hogy a magyarázó változókat hibamentesnek feltételezzük - vagyis nem tartalmaznak mérési hibát. Bár ez a feltétel sok esetben irreális, ennek elvetése a lényegesen bonyolultabb, változók hibáinak modelljéhez vezet.

- Linearitás. Ez azt jelenti, hogy a kimeneti változó (y) átlaga a paraméterek (regressziós együtthatók) és a magyarázó változók (x) lineáris kombinációja. Fontos megjegyezni, hogy ez a feltétel sokkal kevésbé korlátozó, mint amilyennek elsőre tűnhet. Mivel a magyarázó változókat (x) fix értékként kezeljük (lásd feljebb, a Gyenge exogenitás feltételénél), a linearitás valójában csak a paraméterek korlátozása. Maguk a magyarázó változók önkényesen transzformálhatók, és valójában ugyanazon mögöttes magyarázó változó több példánya is hozzáadható, mindegyiket másképp transzformálva. Ezt a technikát alkalmazzák például polinomiális regresszióban, amely lineáris regressziót alkalmaz a kimeneti változó illesztésére egy magyarázó változó tetszőleges polinomiális függvényeként (egy adott rangsorig). Ennyi rugalmasság mellett az olyan modellek, mint a polinomiális regresszió, gyakran „túl sok erővel” rendelkeznek abban a tekintetben, hogy hajlamosak az adatok túlillesztésére. Ennek eredményeként általában valamilyen szabályozást kell alkalmazni, hogy megakadályozzuk az ésszerűtlen eredmények megjelenését a becslési folyamatban. Gyakori példák a gerincregresszió és a lasszó regresszió. Bayes lineáris regresszió is alkalmazható, amely természeténél fogva többé-kevésbé védett a túlillesztés problémájával szemben. (Valójában a gerincregresszió és a lasszó regresszió is a Bayes-féle lineáris regresszió speciális eseteinek tekinthetők.)

- Állandó variancia (más néven homoskedaszticitás). Ez azt jelenti, hogy a kimeneti változó (y) különböző értékeinek hibája azonos szórással rendelkezik, függetlenül a magyarázó változók (x) értékeitől. A gyakorlatban ez a feltételezés érvénytelen (vagyis a hibák heteroszkedasztikusak), ha a kimeneti változó széles skálán változhat. Annak érdekében, hogy ellenőrizzük a heterogén hibaváltozást, vagy ha a maradéktagok (reziduálisok) mintázata megsérti a homoszkedaszticitás modell feltételeit (a hiba ugyanúgy változik a „legjobban illeszkedő vonal” körül az x összes pontjára), körültekintően vizsgáljuk meg a maradék hiba és a magyarázó változók értékei közötti kapcsolatot: szisztematikus változás következik be az abszolút vagy négyzetes maradéktagokban, ha a magyarázó változókkal ábrázoljuk. Ez azt jelenti, hogy a hibák nem oszlanak el egyenletesen a regressziós vonalon. A heteroszkedaszticitás azt eredményezi, hogy a pontok körül megkülönböztethető varianciák átlagolódnak, amely pontatlanul reprezentálja a vonal összes varianciáját. Valójában a maradéktagok csoportosulva jelennek meg az előre jelzett ábráikon a lineáris regressziós vonal mentén elhelyezkedő pontok nagyobb és kisebb értékeinél, és a modell átlagos négyzethibája pontatlan lesz. Jellemzően például egy olyan kimeneti változónak, amelynek az átlaga nagy, nagyobb lesz a szórása, mint annak, amelynek az átlaga kicsi. Például egy olyan személynek, akinek éves jövedelmét 100 000 dollárra jósolják, könnyen 80 000 vagy 120 000 dolláros lehet tényleges jövedelme (a szórás 20 000 dollár körüli), míg egy másik, 10 000 dolláros jövedelemmel rendelkező személynek valószínűleg nem ugyanaz a 20 000 dollár körüli szórás lesz jellemző a jövedelmére, ami azt jelentené, hogy tényleges jövedelme 10 000 és 30 000 dollár között változik. (Valójában, amint a példa is mutatja, sok esetben - gyakran ugyanazokban az esetekben, amikor a normális eloszlású hibák feltétele nem teljesül - a varianciát vagy a szórást az átlaggal arányosnak, és nem állandónak kell becsülni.) Egyszerű lineáris regressziós becslési módszerek kevésbé pontos paraméterbecslést és félrevezető következtetési mennyiségeket adnak (például standard hibákat, ha jelentős heteroszkedaszticitás van jelen). A különböző becslési technikák (pl. súlyozott legkisebb hibanégyzetek és heteroszkedaszticitás-konzisztens standard hibák) azonban a heteroszkedaszticitást meglehetősen általános módon kezelhetik. A Bayes-féle lineáris regressziós technikák akkor is alkalmazhatók, amikor feltételezzük, hogy a variancia az átlag függvénye. Bizonyos esetekben az is megoldható, hogy a kimeneti változót transzformáljuk (pl. a lineáris regressziós modellt használva a kimeneti változó logaritmusát illesztjük az egyenesre, ami azt jelenti, hogy a válaszváltozó log-normális eloszlású lesz, nem pedig normális).

- A hibák függetlensége. Ez azt feltételezi, hogy a kimeneti változók hibái nem korrelálnak egymással. (A tényleges statisztikai függetlenség erősebb feltétel, mint a puszta korreláció hiánya, ezért gyakran nincs szükség a hibák függetlenségének teljesülésére. Ugyanakkor hasznos lehet, ha ismert a fennállása.) Egyes módszerek (pl. általánosított legkisebb négyzetek) képesek kezelni a korrelált hibákat, bár jellemzően lényegesen több adatot igényelnek, hacsak nem használnak valamiféle szabályozást a modell elfogulatlanságára a korrelálatlan hibák feltételezéséhez. A probléma kezelésének általános módja a Bayes-féle lineáris regresszió.

- Nincs tökéletes multikollinearitás a magyarázó változókban. A magyarázó változók nem korrelálhatnak egymással túl erősen (r>,08 kisebb); különben tökéletes multikollinearitás áll fenn. Ennek oka lehet két vagy több tökéletesen korreláló magyarázó változó (pl., ha ugyanazt a magyarázó változót tévesen adják meg kétszer, akár az egyik másolat átalakítása nélkül, akár az egyik másolat lineáris átalakításával). Akkor is előfordulhat, ha a becsülendő paraméterek számához képest túl kevés adat áll rendelkezésre (pl. kevesebb adatpont, mint regressziós együtthatók). Tökéletes multikollinearitás esetén a β paramétervektor nem lesz azonosítható - nincs egyedi megoldása. Legfeljebb néhány paramétert leszünk képesek azonosítani, azaz szűkíteni az értékét az Rp valamilyen lineáris alterére. Lásd a részleges legkisebb négyzetek regresszióját. A multikollinearitással rendelkező lineáris modellek illesztésére is fejlesztettek ki módszereket; ezek közül néhány további feltételhez kötött, például a „hatás ritkasága" - vagyis a hatások nagy része pontosan nulla. Fontos megjegyezni, hogy a paraméterbecsléshez használt, számítási szempontból drágább, iterált algoritmusok, mint amiket az általánosított lineáris modellekben használnak, nem szenvednek ettől a problémától. Lásd még: többszörös lineáris regresszió.

Ezen a feltételeken túl az adatok számos más statisztikai tulajdonsága is erősen befolyásolja a különböző becslési módszerek hatékonyságát:

- A hibatagok és a regresszorok közötti statisztikai kapcsolat fontos szerepet játszik annak meghatározásában, hogy egy becslési eljárás rendelkezik-e kívánatos mintavételi tulajdonságokkal, mint például az elfogulatlanság és következetesség.

- A magyarázó változók (x) elrendezése vagy valószínűség-eloszlása nagyban befolyásolja a β becslésének pontosságát. A mintavétel és a kísérleti elrendezés a statisztikák fejlett alterületei, amelyek útmutatást nyújtanak az adatok összegyűjtéséhez oly módon, hogy a β pontos becslését elérjék.

Többszörös lineáris regresszió[szerkesztés]

A fent tárgyalt egyszerű lineáris regressziós modellt általánosíthatjuk úgy, hogy egy helyett k magyarázóváltozót vonunk be a modellbe, és ezek hatását becsüljük y-ra. Ez lehetőséget ad arra is, hogy a magyarázóváltozókban lévő nemlinearitást beépítsük a modellbe.

Legyen a mintanagyság, a magyarázóváltozók száma. Egy ( elemszámú) adott minta esetén a többszörös lineáris regresszió a következőképpen írható:

ahol ' a transzponálást jelöli, és a két vektor közti skalárszorzatot jelenti.

A fenti egyenleteket felírhatjuk mátrix alakban is, ami megkönnyíti a modell algebrai kezelését. Ehhez legyen

Ekkor a többszörös lineáris regressziós modell a következő:

Ebben az általános modellben a regressziós "egyenes" helyett egy k dimenziós hipersíkot szeretnénk találni egy k+1 dimenziós térben. Megjegyzendő, hogy lehet n darab 1-esből álló vektor is. Így a fenti modell magában foglalja a konstans együtthatót tartalmazó modellt.

A többszörös lineáris regressziós modell megengedi, hogy a magyarázóváltozók korreláltak legyenek egymással. Így viszont az l-edik változó hat önmagában y-ra, és esetlegesen j-n keresztül is. A becsült többszörös lineáris regressziós modell tulajdonsága, hogy paramétert a j-edik magyarázóváltozó y-ra vonatkozó parciális hatásaként kell értelmezni. Ez a parciális értelmezés azt jelenti, hogy a j-edik paraméter a többi k-1 változó y-ra hatását kiküszöbölve mutatja a j-edik magyarázóváltozó hatását. Ezt mutatja a következő összefüggés:

ahol a j-edik magyarázóváltozó többi k-1 magyarázóváltozóra regresszált regresszióból származó becsült maradéktag (reziduum).[2] Az egyszerű lineáris regresszióban érdemi magyarázóváltozó x-en kívül nem szerepel, így látható a kapcsolat a két modell között.[3]

Nemlinearitások kezelése és értelmezése[szerkesztés]

A lineáris regressziós modell csak a paramétereiben kell, hogy lineáris legyen. Így, amennyiben nemlineáris kapcsolatot feltételezünk egy (vagy több) magyarázóváltozó és a magyarázott változó között, úgy lehetséges a magyarázóváltozókat nemlineárisan transzformálni (pl. négyzetre emelés, logaritmálás), majd a transzformált magyarázóváltozót is beépíteni a modellbe. Például ha az életkor (K) és a jövedelem (J) kapcsolatáról azt gondoljuk, hogy fordított U formát követ, akkor ezt a nemlinearitást a következő modellel ragadhatjuk meg:

A becslési eljárások megengedik, hogy negatív értéket vegyen fel, így a becslés során megkaphatjuk a fordított U formát.

Amennyiben azt gondoljuk, hogy a kor növekedésével a jövedelem exponenciálisan növekszik, vagyis a modell a következő:

akkor J természetes alapú logaritmusát véve (ln(J)), és azt használva függő változónak a becsülendő modell a következő lesz:

ami egy lineáris regressziós modell.

Figyelni kell azonban arra, hogy a változók transzformálása esetén a paraméterek értelmezése változik az alap lineáris regressziós modellhez képest.

Becslési módszerek[szerkesztés]

Az együtthatók becslésére alkalmazott eljárásokat a becsléselmélet tárgyalja, néhány jelentős alkalmazás:

- a legkisebb négyzetek módszere (angolul Ordinary Least Squares, OLS)

- az általánosított legkisebb négyzetek módszere (Generalized Least Squares , GLS)

- az általánosított momentumok módszere (Generalized Method of Moments, GMM)

- a legnagyobb valószínűség módszere (Maximum Likelihood Estimation, ML)

A módszer alkalmazási területei[szerkesztés]

Többszörös lineáris regresszió pszichológiai vonatkozásai[szerkesztés]

A pszichológiában gyakran előfordul, hogy egyes jelenségek között lineáris kapcsolat van. Ilyen lehet például a munkára való motiváltság és az egyén teljesítményének kapcsolata.

Minél motiváltabb valaki, feltehetően a munkájában is annál jobb teljesítményt tud nyújtani.

A lineáris regresszió analízis -mely egyike a leggyakrabban alkalmazott statisztikai eljárásoknak- egy olyan módszer, melynek segítségével egy vagy több változó értékeiből rendre megbecsülhető egy másik változó értéke. Az eljárás a következő célokra alkalmazható:

- a.) Annak meghatározására, hogy a független változók hatással vannak-e a függő változóra: Van-e összefüggés?

- b.) Annak meghatározására, hogy a független változók milyen mértékben magyarázzák a függő változó ingadozását: Milyen a kapcsolat erőssége?

- c.) A kapcsolat formájának és struktúrájának meghatározása: matematikai egyenlőség felállítása.

- d.) Predikció: függő változó értékeinek előrejelzése.

- e.) Más független változók kontrollálása, amikor adott változó hatását vizsgáljuk.

A pszichológiában számos olyan jelenség van, amelyet nem tudunk közvetlenül mérni, vagy azért mert nem tudjuk számszerűsíteni, ilyen például a munkahellyel való elégedettség, vagy azért, mert valamilyen jövőbeli eseményre vonatkozik, mint például a pszichoterápia sikeressége.

Vannak olyan tényezők, amelyek befolyásolhatják ezeket a jelenségeket számszerűen is, az előző példáknál maradva ilyenek a fizetés nagysága, a nem, az életkor, és ezek számszerűen is mérhetők. Ez azt jelenti, hogyha megmérjük ezeket a tényezőket, akkor következtetni tudunk általuk a munkahellyel való elégedettségre, előre jelezni tudjuk azt.

Az előrejelzés a pszichológiában is ugyanolyan fontos, mint bármely más tudományterületen. Például a pszichoterápia várható hatékonyságát előre jelezhetjük a kliens életkora, a terápiára való motiváltsága, környezete támogató ereje, a terapeuta szaktudása, a probléma súlyossága szerint. Egy iskolai képességeket vizsgáló teszt alapján megjósolhatjuk az iskolai teljesítményt, a tanulmányi átlagot. Ha egy gépírónő gépírási próbatesztben jól teljesít, feltehető, hogy ténylegesen a munkájában is.

De természetesen ezek az előrejelzések nem tökéletesek. Az ilyen kapcsolat nem feltétlenül jelent oksági viszonyt, csak annyit jelent, hogy egy változó értékei megjósolhatók a többi változó ismeretében. Ilyen viszony lehet a testmagasság és az értelmi képesség között, hiszen az nem jelenthető ki, hogy a nagyobb testmagasság az értelmi képesség növekedését okozza.

Jelen esetben egy harmadik tényező is áll a háttérben: az életkor. Vagyis az életkor emelkedésével a fejlődés során a testmagasság is növekszik, mellyel együtt járhat az értelmi képesség pozitív irányú változása is.

Amikor pszichológiai vizsgálatot végzünk, szükséges, hogy a vizsgált személy jellemzőit, tulajdonságait számszerű faktorként adjuk meg. Ezeket a számszerű faktorokat nevezzük változóknak. Ezeket a változókat használjuk annak vizsgálatára, hogy egyes jelenségek miként befolyásolnak más jelenségeket, vizsgáljuk, hogy formalizálható–e ez a hatás, illetve egyes változók értékeiből következtethetünk-e más változók értékeire. Két változó közötti szisztematikus összefüggés legegyszerűbb formája a lineáris kapcsolat, amely alapján megmondható, milyen mértékű változás áll be y változóban, ha x adott mértékben változik. Megfelelő képlet alkalmazásával bizonyított, hogy a munkahelyi elégedettség és a fizetés között a kapcsolat lineáris. Minél több a fizetés, annál elégedettebb a személy.

A legtöbb pszichológiai vizsgálatnak nem az a célja, hogy indexszámmal fejezze ki két változó között a kapcsolatot, hanem előjelzőket (prediktorokat) szeretne kialakítani azáltal, hogy meghatározza a két változó közti függvényszerű viszonyt. A függvényszerű összefüggés alapja, hogy valamilyen módon adatokat kapunk személyekről, ugyanazon személyektől adatokat gyűjtenek az előjelző (prediktor) vagy független változóra vonatkozóan, valamint a cél- vagy függő változóra vonatkozóan is. A prediktor változóból több is lehet, ezek alapján végezzük a becslést, a célváltozó pedig az, amelyet meg szeretnénk becsülni. Például a pszichoterápiában a beteg életkora, motiváltsága a függő, a terápia hatékonysága a célváltozó.

A lineáris regresszió-számítás során a változók adatait egy koordináta rendszerben ábrázolhatjuk, ahol a vízszintes tengely a független és a függőleges tengely a függő változó. A fizetés és elégedettség példájánál maradva a vízszintes tengelyen a fizetést, a függőleges tengelyen az elégedettséget jelöljük. Az összetartozó értékpárokat pontdiagrammal ábrázoljuk. Az eljárás során a ponthalmazra leginkább illeszkedő egyenest (regressziós egyenes) keressük. A leginkább illeszkedő azt jelenti, hogy az egyes pontok a regressziós egyenestől függőleges irányban vett távolságainak, vagyis a hibáknak a négyzetes összege a lehető legkisebb. A regressziós egyenes jellemzésével tulajdonképpen a változók közötti kapcsolatot is le tudjuk írni. A két változó közötti kapcsolat irányáért és a kapcsolat szorosságáért két faktor a felelős: az egyik az egyenes meredeksége, a másik a pontok egyenestől való távolsága. A két változó közötti kapcsolatot leíró egyenlet alakja y=a+bx.

Lásd még[szerkesztés]

- Legkisebb négyzetek módszere (angolul Ordinary Least Squares, OLS)

- Általánosított legkisebb négyzetek módszere (Generalized Least Squares , GLS)

- Általánosított momentumok módszere (Generalized Method of Moments, GMM)

- Legnagyobb valószerűség módszere (Maximum Likelihood Estimation, ML)

- Többszörös lineáris regresszió

Jegyzetek[szerkesztés]

- ↑ Általános, többváltozós esetben hipersíkot.

- ↑ Ez a formula a Frisch–Waugh tétel speciális eseteként is értelmezhető.

- ↑ Szigorú értelemben véve az egyszerű lineáris regresszió β együtthatójának becslése során is levonjuk a csupa 1-es vektorból álló változó hatását.

Források[szerkesztés]

- Angrist, Joshua és Jörn-Steffen Pischke: Mostly Harmless Econometrics, Princeton University Press, 2008 ISBN 978-0-691-12035-5.

- Hayashi, Fumio: Econometrics, Princeton University Press, 2000 ISBN 978-0-691-01018-2.

- Horowitz, Joel L. és Sokbae Lee: "Semiparametric methods in applied econometrics: do the models fit the data?", Statistical Modelling 2, pp. 3–22, 2002.

- Kemény Sándor – Deák András: Kísérletek tervezése és értékelése (Műszaki, 2000)

- Münnich Ákos – Nagy Ágnes – Abari Kálmán: Többváltozós statisztika pszichológus hallgatók számára (Debrecen, Bölcsész Konzorcium) ISBN 963-9704-04-0.

- Reiczigel Jenő – Harnos Andrea – Solymosi Norbert: Biostatisztika nem statisztikusoknak (Pars Kft., 2007)

![{\displaystyle E[y|X=X_{0}]=m(X_{0},\beta )}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a3885294decfa03bdd5fb02f423e35f0763e2068)